Contents

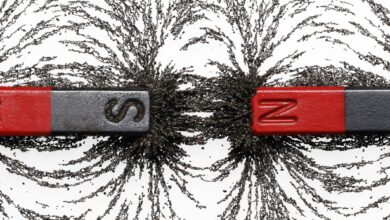

L’entropie est définie comme la mesure quantitative du désordre ou du caractère aléatoire d’un système. Ce concept est issu de la thermodynamique, qui traite du transfert d’énergie thermique au sein d’un système. Au lieu de parler d’une forme d' »entropie absolue », les physiciens discutent généralement du changement d’entropie qui a lieu dans un processus thermodynamique spécifique.

Key Takeaways : Calculer l’entropie

- L’entropie est une mesure de la probabilité et du désordre moléculaire d’un système macroscopique.

- Si chaque configuration est également probable, alors l’entropie est le logarithme naturel du nombre de configurations, multiplié par la constante de Boltzmann : S = kB ln W

- Pour que l’entropie diminue, vous devez transférer de l’énergie de quelque part en dehors du système.

Comment calculer l’entropie

Dans un processus isotherme, la variation de l’entropie (delta-S) est la variation de la chaleur (Q) divisée par la température absolue (T) :

delta-S = Q/T

Dans tout processus thermodynamique réversible, il peut être représenté en calcul comme l’intégrale de l’état initial d’un processus à son état final de dQ/T. Dans un sens plus général, l’entropie est une mesure de la probabilité et du désordre moléculaire d’un système macroscopique. Dans un système qui peut être décrit par des variables, ces variables peuvent prendre un certain nombre de configurations. Si chaque configuration est également probable, alors l’entropie est le logarithme naturel du nombre de configurations, multiplié par la constante de Boltzmann :

S = kB ln W

où S est l’entropie, kB est la constante de Boltzmann, ln est le logarithme naturel et W représente le nombre d’états possibles. La constante de Boltzmann est égale à 1,38065 × 10-23 J/K.

Unités d’entropie

L’entropie est considérée comme une propriété étendue de la matière qui est exprimée en termes d’énergie divisée par la température. Les unités SI de l’entropie sont J/K (joules/dégrés Kelvin).

L’entropie et la deuxième loi de la thermodynamique

Une façon d’énoncer la deuxième loi de la thermodynamique est la suivante : dans tout système fermé, l’entropie du système reste constante ou augmente.

Vous pouvez voir cela comme suit : l’ajout de chaleur à un système entraîne une accélération des molécules et des atomes. Il peut être possible (bien que délicat) d’inverser le processus dans un système fermé sans tirer d’énergie d’un autre endroit ni en libérer pour atteindre l’état initial. On ne peut jamais obtenir un système entier « moins énergétique » que lorsqu’il a commencé. L’énergie n’a nulle part où aller. Pour les processus irréversibles, l’entropie combinée du système et de son environnement augmente toujours.

Idées fausses sur l’entropie

Cette vision de la deuxième loi de la thermodynamique est très populaire et a été utilisée à mauvais escient. Certains affirment que la deuxième loi de la thermodynamique signifie qu’un système ne peut jamais devenir plus ordonné. Ce n’est pas vrai. Cela signifie simplement que pour devenir plus ordonné (pour que l’entropie diminue), vous devez transférer de l’énergie de quelque part en dehors du système, comme par exemple lorsqu’une femme enceinte puise de l’énergie dans la nourriture pour que l’œuf fécondé se transforme en bébé. Cela est tout à fait conforme aux dispositions de la deuxième loi.

L’entropie est également connue sous le nom de désordre, de chaos et de hasard, bien que ces trois synonymes soient imprécis.

Entropie absolue

Un terme apparenté est « entropie absolue », qui est désigné par S plutôt que ΔS. L’entropie absolue est définie selon la troisième loi de la thermodynamique. On applique ici une constante qui fait que l’entropie au zéro absolu est définie comme étant égale à zéro.